Por Mariano Peyronel

Facebook ha publicado su último Informe de cumplimiento de estándares comunitarios , que cubre todas las eliminaciones de contenido y las acciones de cumplimiento que la plataforma promulgó durante el segundo trimestre de 2021.

El informe incluye algunas notas interesantes sobre tendencias clave, así como avances en los sistemas de detección de Facebook. En primer lugar, al abordar la necesidad clave del momento, Facebook dice que eliminó más de 20 millones de piezas de contenido de Facebook e Instagram por violar sus políticas sobre información errónea relacionada con COVID-19.

» Hemos eliminado más de 3.000 cuentas, páginas y grupos por violar repetidamente nuestras reglas contra la propagación de COVID-19 y desinformación sobre vacunas. También mostramos advertencias en más de 190 millones de piezas de contenido relacionado con COVID en Facebook que nuestro hecho de terceros: comprobar los socios calificados como falsos, parcialmente falsos, alterados o faltantes de contexto «.

A medida que continúa la implementación de la vacuna, contrarrestar estos movimientos es clave para maximizar la aceptación y, dado su alcance masivo, esta es un área importante en la que Facebook, específicamente, debe enfocarse. Por supuesto, Facebook también ha sido ampliamente criticado por proporcionar una plataforma para la desinformación de salud en primer lugar, pero los números aquí indican que Facebook está trabajando para contrarrestar estos elementos, en muchos aspectos, que, idealmente, limitarán el impacto de los mismos.

Te puede interesar: Facebook bloquea de todas sus plataformas a los talibanes

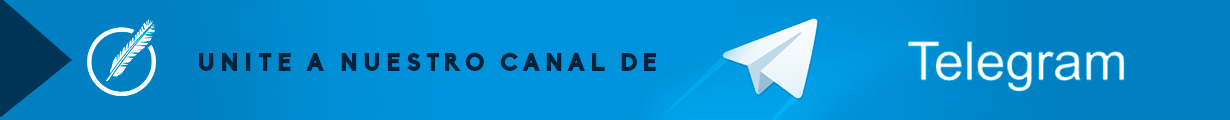

En términos de otras tendencias clave, Facebook dice que sus esfuerzos para abordar el discurso del odio continúan dando resultados positivos:

«La prevalencia del discurso del odio en Facebook siguió disminuyendo por tercer trimestre consecutivo. En el segundo trimestre, fue del 0,05%, o 5 visualizaciones por cada 10.000 visualizaciones, frente al 0,05-0,06%, o de 5 a 6 visualizaciones por cada 10.000 visualizaciones en el primer trimestre.»

En la escala de Facebook, cinco visitas por cada 10,000 aún significaría que una cantidad significativa de discurso de odio está llegando a los usuarios, pero nuevamente, los sistemas de Facebook están mejorando, lo que debería limitar el impacto de tal avance.

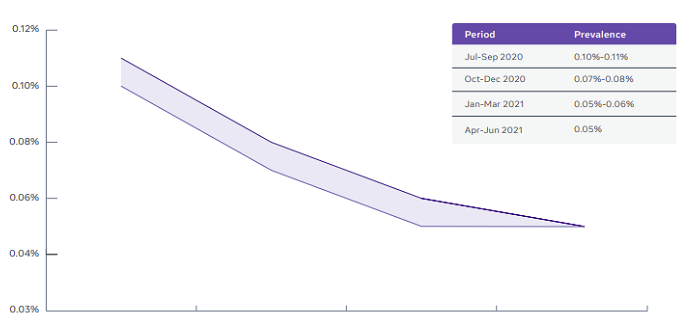

Aunque, al mismo tiempo, vale la pena señalar que Instagram ha experimentado un aumento en la eliminación de discursos de odio.

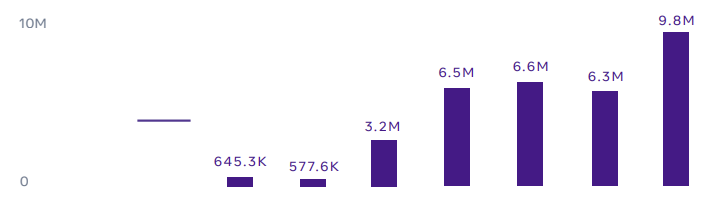

Más acción al respecto es una señal positiva, pero también puede apuntar a un cambio de enfoque para dicho contenido, lo que también se refleja en el crecimiento gradual en la detección de organizaciones peligrosas en la aplicación.

Como puede ver, Instagram está tomando medidas con más de estos grupos a lo largo del tiempo, lo que, nuevamente, es bueno para la aplicación, pero puede apuntar a tendencias cambiantes en el uso de la plataforma, lo que podría ser una preocupación más amplia para IG a lo largo del tiempo.

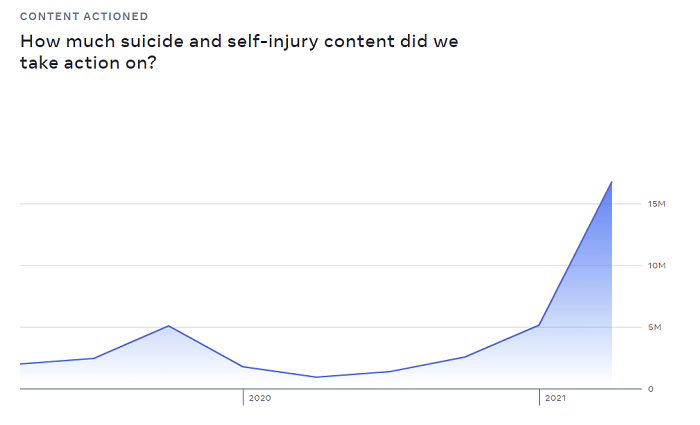

Otro desarrollo preocupante es el fuerte aumento en el suicidio y el contenido de autolesiones en acción.

Facebook dice que este aumento se debe en gran parte a una solución técnica, que permitió a sus moderadores «volver atrás y detectar el contenido infractor que nos perdimos». Pero aún así, es una tendencia preocupante de observar, y vale la pena señalar si ve un aumento continuo en este elemento.

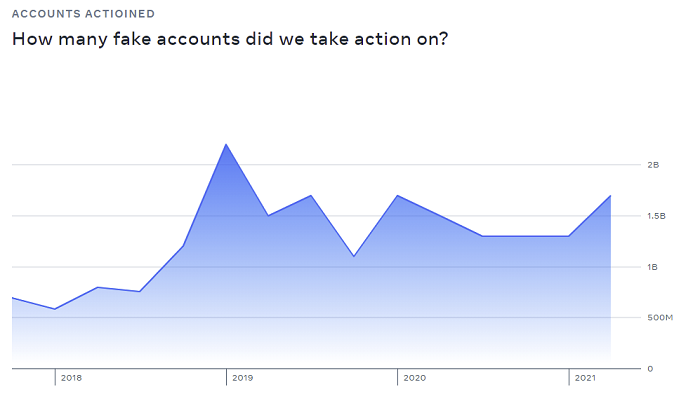

Además, las cuentas falsas en Facebook todavía se encuentran en el 5% del número total de perfiles, la misma tasa que Facebook ha estado reportando durante años .

Facebook dice que tomó medidas contra 1.700 millones de perfiles falsos en el período.

Básicamente, todavía hay muchas cuentas falsas en Facebook, a pesar de sus esfuerzos para detectarlas. De hecho, como se señaló, la tasa relativa de cuentas falsas nunca parece cambiar, incluso a medida que evolucionan sus herramientas, por lo que aparentemente siempre habrá varios millones de perfiles falsos en Facebook en un momento dado.

Lo que parece algo que podría abordarse, pero evidentemente ese no es el caso.

Aún así, en general, Facebook dice que sus procesos de detección automatizados están mejorando:

«Nuestra tasa proactiva (el porcentaje de contenido sobre el que tomamos medidas y que encontramos antes de que un usuario nos lo informara) es superior al 90% en 12 de 13 áreas de política en Facebook y nueve de 11 en Instagram».

Entonces, para contenido ofensivo y violador, Facebook está limitando la exposición, incluso si no puede mejorar sus tasas de exposición en todos los frentes. Es difícil decir qué significa exactamente eso, en un sentido práctico, porque en su mayor parte, las cifras brutas de cumplimiento de Facebook son en gran medida estables en la mayoría de las áreas, a pesar de que las cifras de uso de Facebook aumentan constantemente .

Entonces, esperaría que las estadísticas de cumplimiento total también aumentaran, pero fuera de estos elementos señalados, la mayoría de los demás se han mantenido estables, incluso con las mejoras señaladas.

¿Significa eso que Facebook está mejorando en la detección de violaciones, o peor, o permanece igual? Es un poco difícil de decir, pero Facebook está tomando medidas sobre una gran cantidad de contenido y detecta muchas violaciones antes de que alguien las vea.

Lo que parece bueno, pero no hay nada significativo en estas cifras que indique claramente una mejora importante este trimestre.

Fuente: Social Media Today